KI-Betrug erkennen und vermeiden

Künstliche Intelligenz macht Betrug nicht nur effizienter, sondern die Betrugsversuche auch glaubwürdiger. Vertrauen, eine der zentralen Ressource der digitalen Gesellschaft, kann mit Hilfe von KI einfacher hergestellt werden. Dieser Beitrag gibt einen Überblick, welche Formen von KI-Betrug existieren oder am Entstehen sind, warum sie so gefährlich sind und wie sich Privatpersonen und Unternehmen schützen können.

Was ist KI-Betrug?

KI-Betrügereien sind Betrugsversuche, bei denen Künstliche Intelligenz eingesetzt wird, um Opfer zu täuschen, Identitäten zu fälschen oder Angriffe zu automatisieren. Generative Modelle erstellen dabei Texte, Stimmen, Bilder oder Videos, die von echten Menschen oder seriösen, real existierenden Unternehmen kaum noch zu unterscheiden sind.

Typische Merkmale von KI-gestützten Betrügen sind:

Hochgradig personalisierte Nachrichten, die auf Sprache, Interessen oder Verhalten des Opfers zugeschnitten sind.

Täuschend echte Nachahmungen (Deepfakes) von Stimmen und Gesichtern, etwa von Chefs, Familienmitgliedern oder Prominenten.

Skalierung: Einmal erstellte Betrugs-Workflows können millionenfach automatisiert ausgespielt werden.

Aktuelle Betrugsmaschen mit KI

Im Alltag zeigen sich bereits mehrere Betrugsszenarien, die ohne KI so nicht möglich wären.

Deepfake & Voice-Cloning Betrug

Betrügerinnen und Betrüger imitieren per Deepfake Video oder Sprachklon eine Führungskraft oder nahestehende Person und fordern dringende Überweisungen oder die Herausgabe sensibler Daten.KI-optimiertes Phishing und Social Engineering

E-Mails, SMS und Chatnachrichten werden mit generativer KI sprachlich perfekt und kulturell passgenau formuliert – bisherige klassische Warnsignale wie schlechte Grammatik oder Rechtschreibefehler sind nicht mehr auszumachen.Romance und Investment Scams

Chatbots führen über Wochen oder Monate „Beziehungen“, bauen Vertrauen auf und lenken Opfer dann zu dubiosen Investments oder Geldüberweisungen. Auch vermeintliche „KI-Trading-Bots“ oder „KI-Fonds“ versprechen hohe Renditen und nutzen den Hype um Technologie, um unseriöse Produkte zu verkaufen.

Beispiel für ein Deepfake und Voice-Cloning.

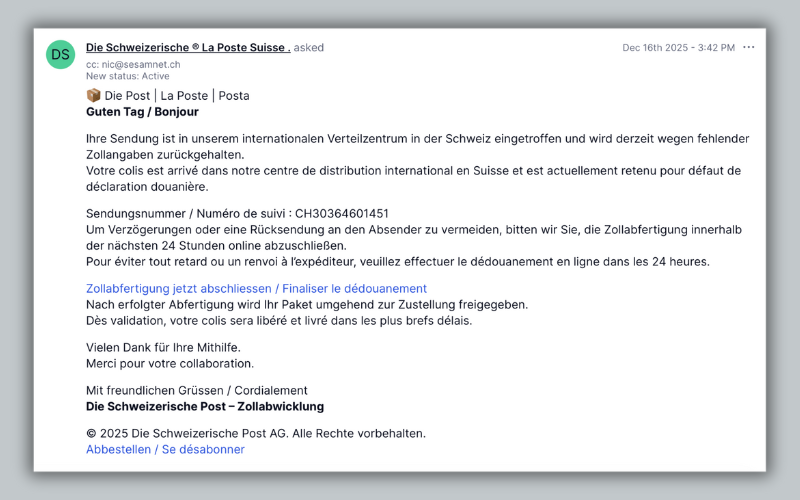

Beispiel für ein KI-optimiertes Phishing E-Mail.

Warum KI-Betrug so gefährlich ist

Die Gefahr von KI-Betrug liegt weniger in einem völlig neuen Angriffstyp, sondern in der Kombination aus Qualität, Tempo und Reichweite.

Glaubwürdigkeit: KI-generierte Inhalte wirken professionell, fehlerfrei und oft emotional glaubwürdig. Das erhöht die Erfolgsquote von Betrugsversuchen deutlich.

Automatisierung: Kriminelle können Social Engineering Angriffe und Identitätsmissbrauch industrialisieren, etwa in „Scam-Fabriken“, die arbeitsteilig Daten sammeln, Inhalte erzeugen und Geldflüsse verschleiern.

Vertrauensverlust: Wenn Stimmen, Bilder und Dokumente jederzeit künstlich erzeugt werden können, wird es schwieriger, Authentizität zu prüfen, sowohl privat als auch in Unternehmen.

Das Bundesamt für Cybersicherheit (BACS) meldet eine deutliche Zunahme von Cybervorfällen, insbesondere im Bereich von Phishing und anderen E-Mail-Angriffen. Immer häufiger setzen Täter dabei KI ein, um Nachrichten überzeugender zu gestalten, Prozesse zu automatisieren und Sicherheitsmechanismen zu umgehen. Diese Entwicklung verdeutlicht, wie wichtig es ist, dass Privatpersonen und Unternehmen aktiv vorsorgen, um sich vor KI-gestütztem Betrug zu schützen.

Schutz für Privatpersonen

Hundertprozentige Sicherheit gibt es nicht aber eine gesunde Skepsis und ein paar einfache Routinen reduzieren das Risiko deutlich.

Identitäten immer über zweiten Kanal prüfen

Bei überraschenden Geldforderungen oder „Dringlichkeits-Anrufen“ von Chef, Familie oder Behörde: Rückruf über eine bekannte Nummer oder einen anderen Kommunikationskanal, nie über die im Anruf genannte Verbindung.Warnsignale ernst nehmen

Zeitdruck, Geheimhaltung („Niemand darf davon wissen“), emotionale Manipulation (Angst, Schuld, Mitleid) und Aufforderungen zu schnellen Überweisungen oder zur Herausgabe von Codes sind klare Alarmzeichen.Digitale Hygiene

Zwei-Faktor-Authentifizierung aktivieren, Passwörter nicht recyceln, Software aktuell halten und Links sowie Anhänge in unerwarteten Nachrichten nicht unreflektiert anklicken. Sicherheitslösungen, die selbst KI nutzen, erkennen zunehmend verdächtige Nachrichten, Webseiten und Anrufe in Echtzeit.

Was Unternehmen jetzt tun sollten

Für Organisationen ist KI-Betrug ein Führungs-, Kultur- und Technologie-Thema zugleich.

Sicherheitskultur & Schulung

Regelmässige Trainings zu KI-basiertem Social Engineering, Deepfakes und CEO-Fraud, ergänzt um klare interne Prozesse: z.B. Vier-Augen-Prinzip und definierte Freigabeschwellen für Zahlungen. Besonders gefährdet sind Finanzabteilungen, HR und IT-Support, die häufig Ziel von hochpersonalisierten Angriffen sind.Technische Massnahmen

Einsatz moderner E-Mail-Security-Lösungen, KI-gestützter Betrugserkennung und Anomalie-Monitoring für Zahlungen und Zugriffe. Viele Unternehmen investieren bereits in Systeme, die synthetische Identitäten, Deepfake-Inhalte und ungewöhnliche Kommunikationsmuster erkennen sollen.Governance und Szenarioplanung

Unternehmen sollten Szenarien entwickeln, in denen KI sowohl als Werkzeug als auch als Angriffsvektor vorkommt: von Deepfake-Pressekonferenzen über gefälschte Kundenkommunikation bis hin zu kompromittierten internen KI-Assistenten. Klare Richtlinien für den Umgang mit generativen Tools, Datenzugriffen und Modellnutzung helfen, Missbrauch durch Mitarbeitende oder Externe zu begrenzen.

Viele KI-Betrugsversuche funktionieren nur, weil sie geschickt auf Social Engineering setzen: Vertrauen aufbauen, Druck erzeugen, Routinen ausnutzen. Wie genau das abläuft, erläutert unser ICT-Experte Marco ausführlich in unserem eigenen Artikel zu Social Engineering.